人工智能已成为医师判读切片重要工具,然「客观理性」的AI真的没有风险吗?成功大学资讯工程学系与哈佛大学医学院合作研究论文「Contrastive learning enhances fairness in pathology artificial intelligence systems」揭露潜藏AI诊断偏差风险,实验结果不同族群间诊断一致性平均提升约88%,登上国际顶尖医学期刊「Cell Reports Medicine」封面论文。

AI在医疗尤其是癌症病理影像分析有助大幅提升诊断效率与准确率。但成大与哈佛的研究指出,现今被广泛应用临床与研究场域的病理影像AI模型,可能在用户未察觉情况下产生系统性诊断偏差,影响不同族群例如西方与东方患者实际诊断品质。

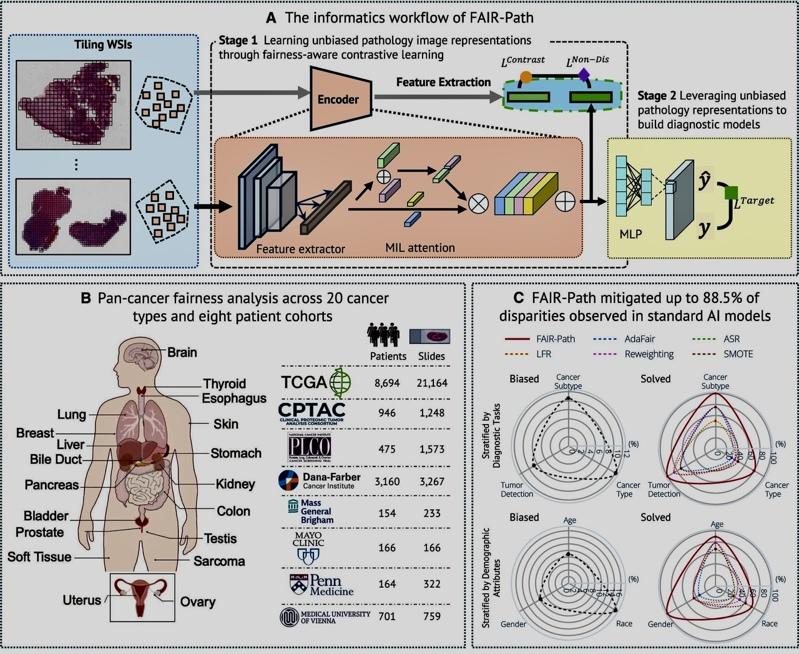

研究团队搜集分析乳癌、肺癌等23种癌症大量病理影像数据,系统性测试多个目前常见的病理影像AI模型。结果显示,这些模型虽然设计初衷是仅根据病理特征判断疾病,但在实际运作AI可能会判读出与患者性别、年龄与族群背景相关潜在线索,并将这些非疾病本质资讯纳入判断依据,导致不同族群间出现显著诊断准确率差异。

整体分析发现,约有3分之1的AI临床诊断可观察到显著的族群间表现差异。这意味着,即使模型在整体平均准确率上表现亮眼,仍可能有部分族群承担较高的误判风险。这项发现,也直接挑战了医疗AI长期被认为「天生客观、公正」的既有想像。

研究团队指出,深入分析诊断偏差的来源不仅来自训练数据中族群比例不均,也与不同疾病在族群间的分布差异,AI在学习过程对某些与族群高度相关、却非疾病本质的影像线索产生「捷径式依赖」有关。这些线索本身未必与疾病直接相关,却与族群背景高度相关,因而在不知不觉中放大诊断不公平风险。

针对「捷径式依赖」,成大资工系特聘教授蒋荣先解释说,有时AI在学习判断疾病时,会不小心「偷懒」,不是看真正跟疾病有关的地方,而是记住一些跟某些族群常一起出现的影像特征。这些特征不一定代表生病,但因为常出现在特定族群身上,AI就误以为它们是判断疾病的重要线索。久而久之,反而可能误判,造成不公平的诊断风险。

为了回应这项挑战,蒋荣先带领博士生蔡沛蓁与苏芳毅聚焦于可信任(Trustworthy)AI,进一步提出 FAIR-Path(Fairness-Aware Representation Learning for Pathology)架构,通过训练策略设计,引导模型专注于与疾病本身高度相关的病理特征,同时降低对族群相关影像线索的依赖。

蒋荣先指出,在训练AI过程中,FAIR-Path 会不断提醒模型:「如果两个病人得的是同一种疾病,就算是来自不同族群,影像特征也应该被判断为相似;但如果疾病不一样,就算族群背景相同,也不应该被混在一起。」就像在教学生看病理切片时,老师会一直纠正:「不要因为病人是某个族群,就以为影像一定代表某种疾病;要看的是肿瘤结构、细胞变化这些真正和疾病有关的线索。」这样训练出来的 AI,比较不会学到偏见,也比较公平。也就是把判断重点放在疾病本身,非病人的族群背景。

实验结果显示,在导入 FAIR-Path 后,模型在不同族群间的诊断一致性平均提升约 88%,且在不牺牲原有整体诊断性能的前提下,显著提升不同族群间的诊断一致性,成功改善模型的公平性与可信赖性,显示该方法具有高度实务应用潜力。

该论文由蒋荣先与哈佛教授担任共同通信作者,并同步获哈佛医学院专文报导,显示研究成果已获国际学术界高度肯定。研究团队表示,这项研究不仅为医疗AI临床提供重要警示,也提出具体可行技术解方,为未来发展更公平、更值得信赖的智能医疗系统奠定关键基础。